یکی از دانشمندان مطرح حوزه هوش مصنوعی در اظهارات خود هشدار داد که کمپانیهای بیگتک (شرکتهای معروف حیطه هوش مصنوعی)، موفق شدهاند حواس جهانیان را از خطرات هوش مصنوعی برای ماهیت نسل بشر ایجاد میکند، پرت کنند.

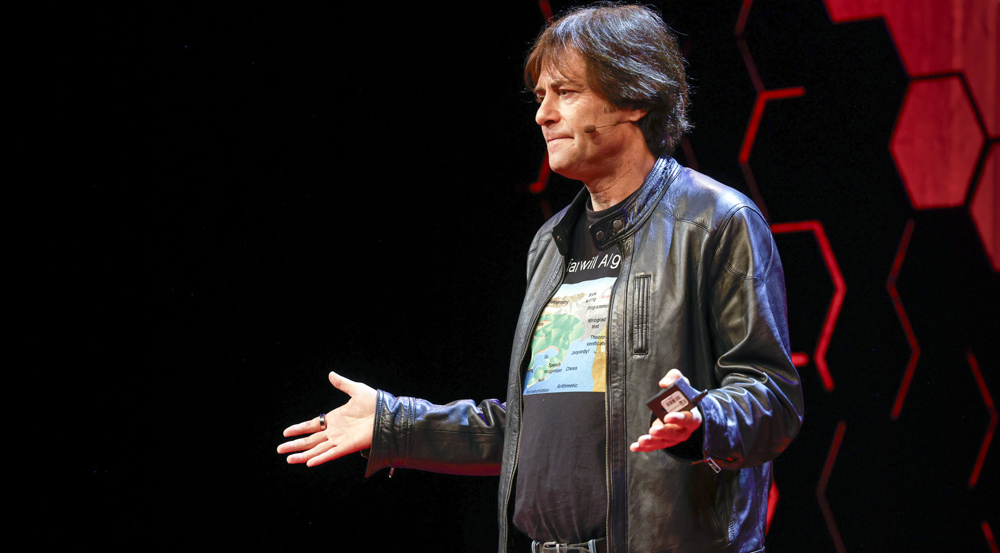

طی مصاحبهای که «مکس تگمارک» در نشست هوش مصنوعی برگزار شده در سئول کره جنوبی با مجله گاردین داشت، این دانشمند گفت: «سال ۱۹۴۲، «انریکو فرمی» اولین رآکتور هستهای با قابلیت تامین خودکار واکنشهای زنجیرهای هستهای را زیر زمین فوتبالی در شیکاگو ساخت. زمانی که فیزیکدانان مطرح آن زمان از این موضوع مطلع شدند واقعا وحشت کردند. زیرا میدانستند که بزرگترین مانع باقیمانده برای ساخت یک بمب اتمی پشت سر گذاشته شده بود. آنها متوجه شدند که با این رویداد فقط چند سال فاصله داشتند. سه سال دیگر، تست ترینیتی در سال ۱۹۴۵ انجام شد.

نامه سرگشاده برای وقفه در تحقیقات هوش مصنوعی

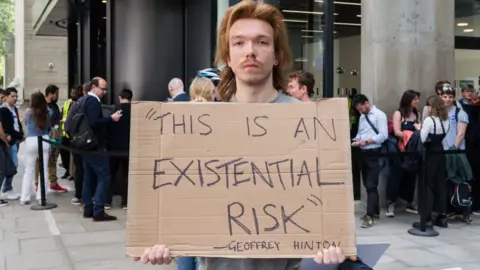

مدلهای هوش مصنوعیای که در حال حاضر میتوانند تست تورینگ «تستی که در آن شخص نمیتواند متوجه شود مخاطبش در یک مکالمه انسان نیست» را با موفقیت پشت سر بگذارند، همان مدلهای خطرناکی هستند که نباید کنترلشان را از دست بدهید. «یاشوا بنجیو» و «جفری هینتون»، مدیرعاملهای کمپانیهای هوش مصنوعی نیز دقیقا به همین دلیل است که دست و پای خود را گم کردهاند. حداقل در فضاهای خصوصی خود!

سازمان Future of Life تگمارک، مسئول پیشبردن درخواست سال پیش بود که به دنبال این ترسها، از مسئولان مربوطه میخواست یک وقفه ۶ ساله در روند تحقیقات پیشرفته هوش مصنوعی ایجاد کنند. تگمارک گفت عرضه مدل OpenAI’s GPT-4 در مارچ آن سال، گل سرسبد این تحقیقات بود. همچنین ثابت کرد که خطرات تا حد غیرقابل قبولی به ما نزدیک شدهاند.

علیرغم جمعآوری هزاران امضا «که متخصصان این حوزه مانند هینتون و بنجیو، دو نفر از سه پدرخوانده هوش مصنوعی که پایهگذار وضعیت کنونی هستند نیز از امضاکنندگان بودند» با درخواست وقفه موافقت نشد. در مقابل، نشستهای خطرات هوش مصنوعی، که دومین جلسه آن در سئول برگزار شد «اولین جلسه مربوط به پارک بلچلی بریتانیا در نوامبر گذشته بود» برای تعیین محدودیتهای هوش مصنوعی، پیشگام هستند.

تگمارک و تأکید بر اولویتگذاری امنیت توسط دولتها

از زمان برگزاری نخستین نشست در «بلچلی پارک»، تمرکز قانونگذاریهای بینالمللی هوش مصنوعی از خطرات تهدیدکننده ماهیت انسان برداشته شده است. طی نشست سئول فقط یکی از سه گروه “سطح بالا” مستقیماً به مسائل امنیتی اشاره کرد. همچنین این گروه نیز “گستره کامل” خطرات را مورد بررسی قرار داد. «از شکافهای اطلاعات خصوصی تا اختلال در بازار کار و نتایج فاجعهبار احتمالی». تگمارک معتقد است که بیاهمیت جلوه دادن یکی از مهمترین خطرات راه درستی نیست و تصادفی نیز نیست.

منتقدان تگمارک بر اساس اظهارات خود این محقق، مسائلی را مطرح میکنند: این محقق از تمام افراد میخواهد سرگرم آسیبهای احتمالی هوش مصنوعی در آینده شوند تا آسیبهای مطرح حال حاضر را نادیده بگیرند. تگمارک این اتهام را رد میکند. در مقابل علت حمایت بدون سر و صدای برخی از رهبران دنیای تکنولوژی را به این صورت توصیف میکند: «فکر میکنیم همه آنها احساس میکنند در موقعیتی غیرممکن گیر افتادهاند. موقعیتی که حتی اگر بخواهند توقف کنند نیز قادر نخواهند بود. اگر مدیرعامل یک شرکت تنباکو روزی از خواب بیدار شود و بداند کاری که دارد انجام میدهد، کار درستی نیست، چه اتفاقی میافتد؟ این مدیرعامل را جایگزین میکنند. پس تنها راهی که میتوانید امنیت را در اولویت قرار دهید این است که دولت استانداردهایی برای امنیت همگان قائل شود.

منبع: دگاردین